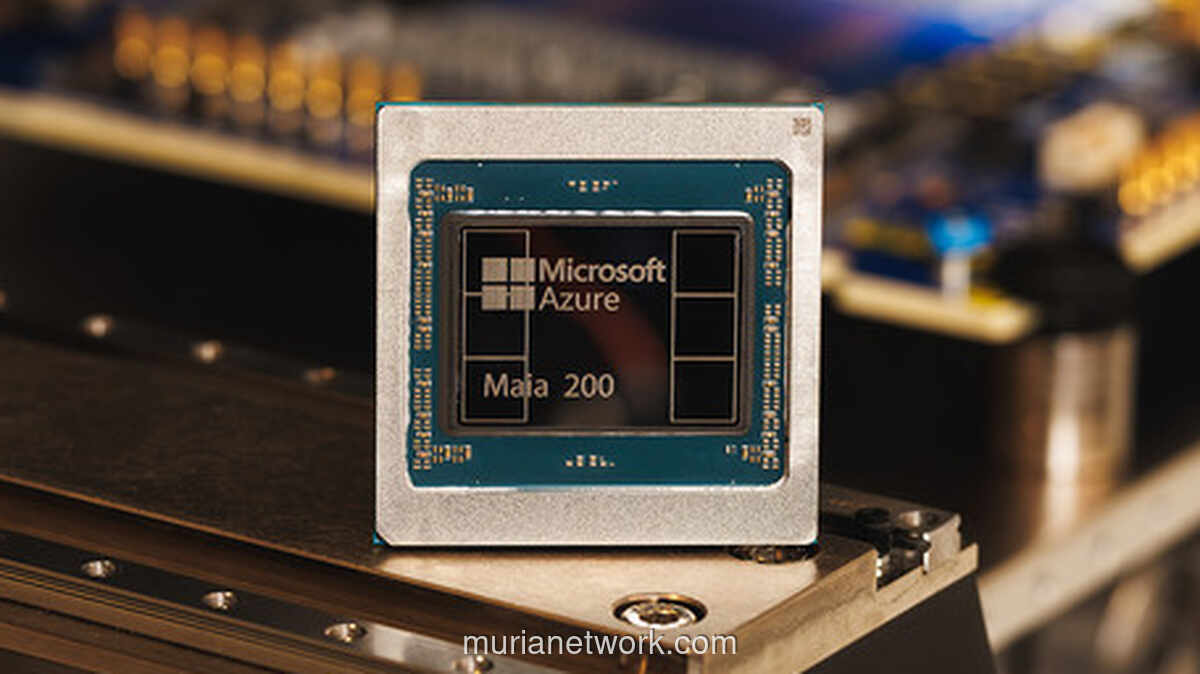

Microsoft baru saja mengumumkan kehadiran chip terbarunya, Maia 200. Ini adalah prosesor khusus yang mereka rancang untuk satu tujuan utama: mempercepat dan membuat proses inferensi kecerdasan buatan jadi jauh lebih efisien. Bagi perusahaan, Maia 200 bukan sekadar chip biasa. Mereka menyebutnya sebagai tulang punggung silikon untuk menjalankan model AI berskala besar, tapi dengan konsumsi daya yang lebih hemat.

Sebagai penerus Maia 100 yang diluncurkan tahun lalu, chip ini membawa lompatan teknis yang cukup signifikan. Menurut rilis resmi, Maia 200 dibekali dengan lebih dari 100 miliar transistor di dalamnya. Hasilnya? Kinerjanya bisa mencapai lebih dari 10 petaflops pada presisi 4-bit, dan sekitar 5 petaflops untuk presisi 8-bit. Angka-angka itu jelas jauh meninggalkan kemampuan generasi sebelumnya.

Nah, bagi yang belum terlalu familiar, inferensi AI itu adalah tahap ketika model kecerdasan buatan sudah jadi dan dijalankan untuk menghasilkan jawaban atau output. Ini berbeda fase dengan proses pelatihan model itu sendiri. Seiring bisnis AI makin meluas, biaya untuk tahap inferensi ini ternyata membengkak dan jadi komponen operasional yang besar.

Makanya, tidak heran jika perusahaan-perusahaan teknologi sekarang berlomba mencari solusi. Mereka ingin menekan biaya itu, tapi tanpa harus mengorbankan performa. Dan Microsoft berharap Maia 200 bisa menjadi jawabannya.

Artikel Terkait

South Carolina Pecahkan Rekor Kasus Campak Terburuk dalam Tiga Dekade

Generasi Digital Indonesia: Antara Peluang dan Tantangan di Balik Layar

Unijo: Kisah Kanguru Pohon Papua yang Bergelantungan di Ambang Kepunahan

Dari Racun hingga Obat: Kisah Pohon Sosis yang Menyimpan Dua Sisi