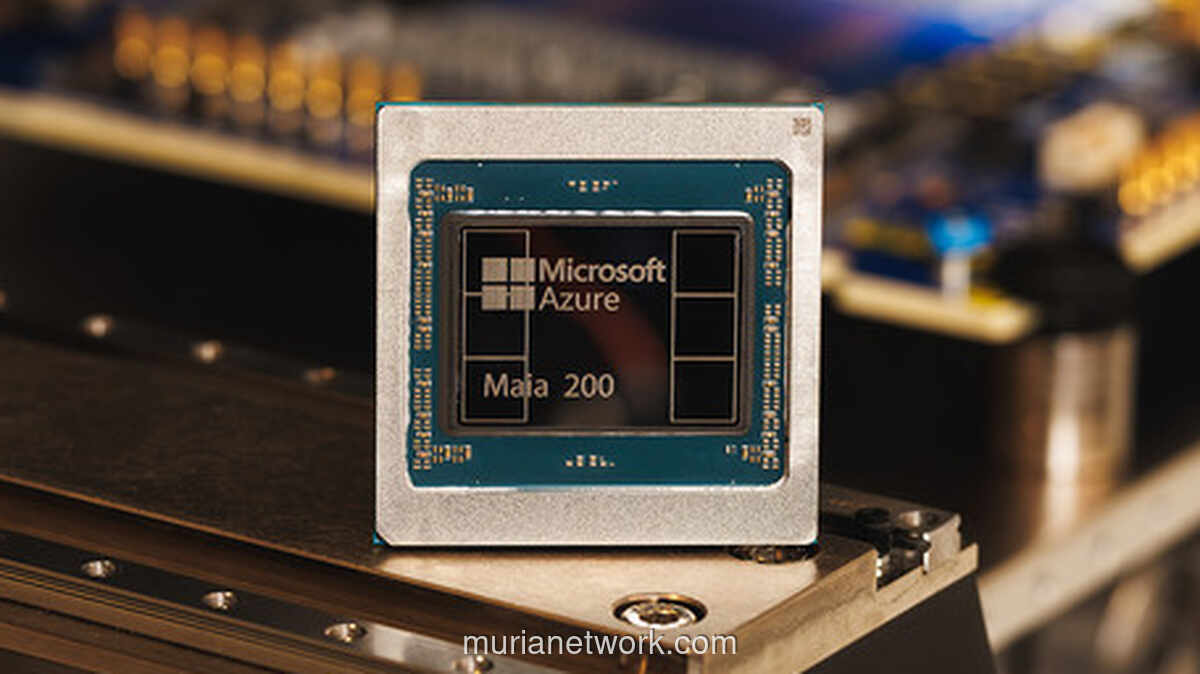

Scott Guthrie, Executive Vice President Cloud AI Microsoft, menjelaskan kapasitas chip ini.

"Secara praktis, satu node Maia 200 dapat dengan mudah menjalankan model-model terbesar saat ini, dengan ruang kapasitas yang masih luas untuk model yang lebih besar di masa depan," ujarnya.

Peluncuran chip ini juga bukan hal yang terjadi dalam ruang hampa. Ini mencerminkan sebuah tren besar di industri. Perusahaan-perusahaan raksasa teknologi kini mulai serius mengembangkan chip mereka sendiri. Tujuannya jelas: mengurangi ketergantungan pada GPU Nvidia yang selama ini mendominasi pasar komputasi AI.

Google punya TPU yang bisa diakses lewat layanan cloud-nya. Di sisi lain, Amazon juga tidak mau ketinggalan dengan mengembangkan chip akselerator AI bernama Trainium. Versi terbarunya, Trainium3, bahkan sudah meluncur Desember 2025 lalu. Chip-cip buatan sendiri ini membantu mereka memindahkan sebagian beban komputasi dari GPU Nvidia dan, tentu saja, berusaha menekan biaya perangkat keras secara keseluruhan.

Artikel Terkait

South Carolina Pecahkan Rekor Kasus Campak Terburuk dalam Tiga Dekade

Generasi Digital Indonesia: Antara Peluang dan Tantangan di Balik Layar

Unijo: Kisah Kanguru Pohon Papua yang Bergelantungan di Ambang Kepunahan

Dari Racun hingga Obat: Kisah Pohon Sosis yang Menyimpan Dua Sisi